Tecnologías de la Comunicación

miércoles, 9 de octubre de 2013

Active Directory

ACTIVE DIRECTORY

¿Qué es Active Directory?

Active Directory (AD) y como funciona; para esto empezaremos por definir (AD), este es el nombre que se le da al servicio de directorio de Microsoft, pero ¿qué es un servicio de directorio?, pues bien, un servicio de directorio es una aplicación o un conjunto de aplicaciones que gestionan los objetos de la red, tales como usuarios y recursos de red y permite a los administradores de la red, tener un control centralizado sobre quien tiene acceso a qué ; prácticamente un servicio de directorio es una base de datos, pero con la diferencia de que esta es optimizada para lectura y cuenta con alternativas avanzadas de búsqueda.Se basa en una estructura jerárquica de objetos, este se divide en tres categorías: recursos, servicios y usuarios, como ya dijimos lo que hace es proporcionar información sóbrelos objetos, además de organizarlos y establecer políticas de seguridad, conocidas en entornos Microsoft como (GPO). Cada uno de estos objetos que se encuentran en AD tienen uno atributos, los cuales se definen en un esquema, el cual también se encarga de decir que clases de objetos se pueden tener en el AD; estos esquemas ya vienen creados en AD y no es recomendable modificarlos.

Básicamente esta es la estructura de Active Directory, antes de implementar un AD, se debe realizar una planificación de como estará estructurado, ya que después de instalado sera un poco complicado modificar dicha estructura; de esta forma se nos facilitara la gestión de los recursos de nuestra red.

Active Directory (AD) es el término que usa Microsoft para referirse a su implementación de servicio de directorio en una red distribuida de computadores. Utiliza distintos protocolos.

De forma sencilla se puede decir que es un servicio establecido en uno o varios servidores en donde se crean objetos tales como usuarios, equipos o grupos, con el objetivo de administrar los inicios de sesión en los equipos conectados a la red, así como también la administración de políticas en toda la red.

Su estructura jerárquica permite mantener una serie de objetos relacionados con componentes de una red, como usuarios, grupos de usuarios, permisos y asignación de recursos y políticas de acceso.

Active Directory permite a los administradores establecer políticas a nivel de empresa, desplegar programas en muchas computadoras y aplicar actualizaciones críticas a una organización entera. Un Active Directory almacena información de una organización en una base de datos central, organizada y accesible. Pueden encontrarse desde directorios con cientos de objetos para una red pequeña hasta directorios con millones de objetos.

Estructura:

Active Directory está basado en una serie de estándares llamados X.500, aquí se encuentra una definición lógica a modo jerárquico.

Dominios y subdominios se identifican utilizando la misma notación de las zonas DNS, razón por la cual Active Directory requiere uno o más servidores DNS que permitan el direccionamiento de los elementos pertenecientes a la red, como por ejemplo el listado de equipos conectados; y los componentes lógicos de la red, como el listado de usuarios.

Un ejemplo de la estructura descendente (o herencia), es que si un usuario pertenece a un dominio, será reconocido en todo el árbol generado a partir de ese dominio, sin necesidad de pertenecer a cada uno de los subdominios.

A su vez, los árboles pueden integrarse en un espacio común denominado bosque (que por lo tanto no comparten el mismo nombre de zona DNS entre ellos) y establecer una relación de «trust» o confianza entre ellos. De este modo los usuarios y recursos de los distintos árboles serán visibles entre ellos, manteniendo cada estructura de árbol el propio Active Directory.

Objetos

Los objetos se enmarcan en tres grandes categorías. — recursos ( impresoras), servicios ( correo electrónico), y usuarios (cuentas, o usuarios y grupos). El AD proporciona información sobre los objetos, los organiza, controla el acceso y establece la seguridad. Cada objeto representa una entidad individual — ya sea un usuario, un equipo, una impresora, una aplicación o una fuente compartida de datos— y sus atributos. Los objetos pueden contener otros objetos. Un objeto está unívocamente identificado por su nombre y tiene un conjunto de atributos—las características e información que el objeto puede contener—definidos por y dependientes del tipo. Los atributos, la estructura básica del objeto, se definen por un esquema, que también determina la clase de objetos que se pueden almacenar en el AD.

Funcionamiento:

Su funcionamiento es similar a otras estructuras de LDAP (Lightweight Directory Access Protocol), ya que este protocolo viene implementado de forma similar a una base de datos, la cual almacena en forma centralizada toda la información relativa a un dominio de autenticación. Una de sus ventajas es la sincronización presente entre los distintos servidores de autenticación de todo el dominio.

A su vez, cada uno de estos objetos tendrá atributos que permiten identificarlos en modo unívoco (por ejemplo, los usuarios tendrán campo «nombre», campo «email», etcétera, las impresoras de red tendrán campo «nombre», campo «fabricante», campo «modelo», campo "usuarios que pueden acceder", etc). Toda esta información queda almacenada en Active Directory replicándose de forma automática entre todos los servidores que controlan el acceso al dominio.

De esta forma, es posible crear recursos (como carpetas compartidas, impresoras de red, etc) y conceder acceso a estos recursos a usuarios, con la ventaja que estando todos estos objetos memorizados en Active Directory, y siendo esta lista de objetos replicada a todo el dominio de administración, los eventuales cambios serán visibles en todo el ámbito. Para decirlo en otras palabras, Active Directory es una implementación de servicio de directorio centralizado en una red distribuida que facilita el control, la administración y la consulta de todos los elementos lógicos de una red (como pueden ser usuarios, equipos y recursos).

Intercambio entre dominios:

Para permitir que los usuarios de un dominio accedan a recursos de otro dominio, Active Directory usa una relación de confianza .La relación de confianza es creada automáticamente cuando se crean nuevos dominios. Los límites de la relación de confianza no son marcados por dominio, sino por el bosque al cual pertenece. Existen relaciones de confianza transitivas, donde las relaciones de confianza de Active Directory pueden ser un ACCESO DIRECTO (une dos dominios en árboles diferentes, transitivo, una o dos vías), BOSQUE (transitivo, una o dos vías), REINO (transitivo o no transitivo, una o dos vías), O EXTERNO (no transitivo, una o dos vías), para conectarse a otros bosques o dominios que no son de Active Directory. Active Directory usa el protocolo V5 de Kerberos, aunque también soporta NTLM y usuarios webs mediante autentificación SSL/TLS.

Confianza transitiva:

Las Confianzas transitivas son confianzas automáticas de dos vías que existen entre dominios en Active Directory. Tenemos:

Las Confianzas explícitas: Son aquellas que establecen las relaciones de forma manual para entregar una ruta de acceso para la autenticación. Este tipo de relación puede ser de una o dos vías, dependiendo de la aplicación.Las Confianzas explícitas se utilizan con frecuencia para acceder a dominios compuestos por computadoras con Windows NT 4.0.

La Confianza de acceso directo: Es, esencialmente, una confianza explícita que crea accesos directos entre dos dominios en la estructura de dominios. Este tipo de relaciones permite incrementar la conectividad entre dos dominios, reduciendo las consultas y los tiempos de espera para la autenticación.

La Confianza entre bosques permite la interconexión entre bosques de dominios, creando relaciones transitivas de doble vía. En Windows 2000, las confianzas entre bosques son de tipo explícito, al contrario de Windows Server 2003.

Resumen:

Servicios de directorio es una base de datos distribuida que permite almacenar información relativa a los recursos de una red con el fin de facilitar su localización y administración. Microsoft Active Directory es la implementación más reciente de Servicios de directorio para Windows 2000. Las cuestiones básicas relacionadas con un centro de servicios de directorio giran alrededor de la información que se puede almacenar en la base de datos, cómo se almacena, cómo se puede consultar información específica y qué se puede hacer con los resultados. Puede consultar el directorio con un nombre de usuario para obtener información como el número de teléfono o la dirección de correo electrónico de ese usuario. Los servicios de directorio también son lo suficientemente flexibles como para permitir la realización de consultas generalizadas.

Los servicios de directorio también ofrecen la ventaja de suponer un único punto de entrada para los usuarios a la red de toda la empresa. Los usuarios pueden buscar y usar recursos en la red sin conocer el nombre o la ubicación exactos del recurso. Igualmente, puede administrar toda la red con una vista lógica y unificada de la organización de la red y de sus recursos.

lunes, 23 de septiembre de 2013

RED AD HOC

RED AD HOC

Una red ad hoc inalámbrica es un tipo de red inalámbrica descentralizada. La red es ad hoc porque no depende de una infraestructura pre-existente, como routers (en redes cableadas) o de puntos de accesos en redes inalámbricas administradas. En lugar de ello, cada nodo participa en el encaminamiento mediante el reenvío de datos hacia otros nodos, de modo que la determinación de estos nodos hacia la información se hace dinámicamente sobre la base de conectividad de la red.

Una red ad hoc se refiere típicamente a cualquier conjunto de redes donde todos los nodos tienen el mismo estado dentro de la red y son libres de asociarse con cualquier otro dispositivo de red ad hoc en el rango de enlace. Las redes ad hoc se refieren generalmente a un modo de operación de las redes inalámbricas IEEE 802.11.

Este tipo de red permite la adhesión de nuevos dispositivos, con el solo hecho de estar en el rango de alcance de un nodo ya perteneciente a la red establecida. El protocolo que rige este tipo de comunicaciones es el 802.11, que define todos los parámetros necesarios para establecer la comunicación entre dispositivo inalámbricos. El principal inconveniente de este tipo de redes radica en el número de saltos que debe recorrer la información antes de llegar a su destino.

Las redes ad hoc son muy fáciles de implementar, siendo muy utilizadas hoy en día, sobre todo en el ámbito doméstico. Se utilizan, por ejemplo, en la transferencia de datos vía Bluetooth entre dispositivos móviles, o entre otros dispositivos como impresoras.

Para configurar una red ad hoc es necesario tener lo siguiente:

Home Premium

Business

Ultimate

Enterprise

Una red ad hoc es una conexión temporal entre equipos y dispositivos usada para un fin específico como, por ejemplo, compartir documentos durante una reunión o participar en juegos informáticos de varios jugadores. Además, puede compartir temporalmente una conexión a Internet con otros usuarios de la red ad hoc, de modo que dichos usuarios no tienen que configurar sus propias conexiones a Internet. Las redes ad hoc sólo pueden ser inalámbricas, de modo que deberá tener un adaptador de red inalámbrica instalado en el equipo para configurar una red ad hoc o para unirse a ella.

1. Para abrir Conectarse a una red, haga clic en el botón Inicio y, a continuación, en Conectarse a.

2. Haga clic en Configurar una conexión o red.

3. Haga clic en Configurar una red ad hoc (de equipo a equipo), haga clic en Siguiente y, a continuación, siga los pasos del asistente.

Nota:

• Si uno o más equipos conectados en red pertenecen a un dominio, debe tener una cuenta de usuario en dichos equipos para ver los elementos compartidos y tener acceso a éstos.

• Si los equipos conectados en red no pertenecen a un dominio, pero desea exigir a otros usuarios que tengan una cuenta de usuario en el equipo para tener acceso a los elementos compartidos, active el uso compartido con protección por contraseña en el Centro de redes y recursos compartidos.

Para activar el uso compartido con protección por contraseña:

a. Para abrir Centro de redes y de recursos compartidos, haga clic en el botón Inicio , en Panel de control, en Red e Internet y, finalmente, en Centro de redes y de recursos compartidos.

b. En Compartir y detectar, si está desactivado el uso compartido con protección por contraseña, haga clic en el botón de flecha para expandir la sección, haga clic en Activar el uso compartido con protección por contraseña y, a continuación, haga clic en Aplicar. Si se le solicita una contraseña de administrador o una confirmación, escriba la contraseña o proporcione la confirmación.

• Una red ad hoc se elimina automáticamente después de que todos los usuarios se desconecten de la red o cuando la persona que la haya configurado se desconecte y salga del intervalo de los otros usuarios de la red, a menos que decida convertirla en una red permanente en el momento de crearla.

• Si comparte la conexión a Internet, se deshabilitará la Conexión compartida a Internet (ICS) si:

• Se desconecta de la red ad hoc.

• Crea una red ad hoc sin desconectarse de la antigua red ad hoc para la que haya habilitado ICS.

• Cierra la sesión y, continuación, vuelve a iniciarla (sin desconectarse de la red ad hoc).

Si configura una red ad hoc, comparte la conexión a Internet y, a continuación, alguien se conecta al mismo equipo con Cambio rápido de usuario, seguirá compartiéndose la conexión a Internet, aunque no tuviese intención de compartirla con dicha persona.

domingo, 22 de septiembre de 2013

Requerimiento para windows server

REQUERIMIENTO DE DE HARDWARE EL SISTEMA OPERATIVO WINDOWS SERVER 2008 R2

Sistema Operativo Requisitos mínimos

Requisitos recomendados

Windows

Server 2008 R2

:

Instalar en una máquina virtual con los requerimientos recomendados para su

instalación. La máquina debe tener 2 discos adicionales de4GB cada uno sin

particionar.

Windows Server 2008 R2 Procesador: 1GHz Procesador:

2GHzRAM: 512MB RAM: 1GBDisco Duro: 8GB Disco Duro: 40GBVideo: Super VGA Video:

Super

Los requerimientos mínimos para Windows Server 2008 son los siguientes:

|

Mínimos

|

Recomendados

|

|||

|

Procesador

|

2 GHz

o superior

|

|||

|

Memoria

|

|

|||

|

Tarjeta

gráfica

|

Super VGA (800 x 600)

|

|

||

|

Espacio

libre HDD

|

50 GB

o más

Los

equipos que dispongan de más de 16 GiB de memoria RAM requerirán más

espacio en disco para archivos de paginación y volcado.

|

|||

|

Unidades

|

DVD-ROM

o mejor

|

|||

|

Otros

dispositivos

|

||||

Centos:

: Instalar en una máquina virtual con las siguientes características:

Memoria RAM

: 800MB

Disco duro 1

: 8GB

Disco duro 2

: 2GB

2

Adaptadores de red:

Uno en modo NAT y otro en red

interna

Particionamiento:

Usar LVM (Logical Volume Managemen–Administrador

de volúmenes lógicos) para manejar un solo volumen lógico cuya capacidad sea la

suma deldisco1 y del disco 2 (10GB). Tenga en cuenta que desaparece la noción

de disco físico ya parece el concepto de

volumen lógico

: Describe una unidad lógica de espacio en disco que se compone de

espacio contenido en uno o más discos físicos.

NOTA: Las

máquinas virtuales con los sistemas operativos

Debían Centos y Windows

Server 2008 R2serán usadas durante el desarrollo de esta fase del proyecto.

jueves, 29 de agosto de 2013

Ventajas de los discos duros virtuales

ventajas de los discos duros virtuales

Trabajos disponibles en cualquier lugar: en

la casa o la de un amigo, la escuela, la universidad.

“Subir”

archivos en tu casa y “bajarlos” en el colegio, universidad o trabajo.

Compartirlos

trabajos, como presentaciones y videos, con otros estudiantes y profesores sin

tener que enviarlos directamente por e-mail.

.

Usted

puede usar esta zona para compartir archivos en forma individual, grupal o en

redes.

Puede

publicar los documentos en su página Web.

No

necesita darles acceso directo a otras personas a su PC para que puedan acceder

a los archivos que desea compartir.

Los discos duros virtuales

Disco

virtual

Un disco duro virtual (VHD son sus siglas en inglés) es un

espacio ofrecido por empresas para sus clientes como una solución al

almacenamiento de datos. Emula a un disco duro/rígido de computadora/ordenador

y gracias a la conexión a Internet, permite el acceso desde cualquier lugar.

Generalidades

Este emulador de disco duro, funciona con algunas de las características

de un disco duro externo, es una idea parecida a la de hosting. Se utiliza para prevenir problemas informáticos, ya que permite tener

la información guardada externamente al ordenador, móvil, pda habitual, en un

servidor especialmente dedicado a eso. Además, se puede utilizar como sistema

de backup.

Como todos los discos duros, tiene una capacidad limitada, pero a

diferencia de éstos, se le puede fijar un tamaño máximo de archivo al que

admitir, sin importar de qué tipo sea éste. Se puede configurar de modo que el

sistema transmita los datos cifrados y sólo se pueda acceder mediante una

contraseña. Se puede acceder a estos servidores desde cualquier navegador (por

ejemplo el 4shared o el Facebook) conectándose a la dirección

virtual pertinente. En algunos casos, también se puede acceder mediante un

programa FTP seguro (como por ejemplo el Secure Shell).

Algunas empresas ofrecen como servicio para sus clientes o como negocio

para la gente un espacio virtual de almacenamiento. Utilizan como

características principales para sus clientes las siguientes ventajas:

- Compatibilidad con programas de aceleración de descargas.

- Subida múltiple de archivos.

- Sistema de progreso de subida.

- Usuarios anónimos pueden subir archivos.

- Diferentes niveles para cuando se tengan que compartir archivos.

- Continuación de transferencia interrumpida.

- Poder cambiar la descripción del archivo.

- Previsualización del archivo con creación automática de iconos.

- Álbum fotográfico.

- Poder obtener archivos de otras páginas web.

- Enlace de descarga directa.

- Previsualización de contenidos de un archivo zip.

- Descarga múltiple de archivos.

- Reproducción de archivos de música.

- Edición de archivos de texto.

- Función de búsqueda.

Evolución

Es un servicio bastante reciente, ya en funcionamiento. Primero

surgieron servidores web donde la gente subía el archivo deseado y obtenía un

enlace que le permitía bajárselo a cualquier persona desde cualquier ordenador.

Algunos ejemplos de estos servicios son ImageShack, Megaupload, MediaFire o Rapidshare. Más

recientemente han surgido iniciativas de servidores de correos como Google con

su servicio Gmail o Windows con su servicio Windows Live, que dan al

usuario una unidad virtual de disco duro para su propio uso.

Pero, aun se cree que el uso de los CD, DVD, discos duros USB, memorias

flash USB, etcétera perdurará por mucho tiempo,

en especial las últimas.

Nueva Generación de Discos

Virtuales

Con la presentación de [Windows 8] Consumer Preview, [Microsoft]

Presento el nuevo formato .vhdx el cual elimina el límite de 2 TB y por defecto

es extensible, es decir se extiende cuando lo necesita, esta función puede ser

desactivada.

Una unidad virtual se puede crear a partir de la memoria RAM (Disco

RAM), utilizando una parte de esta como unidad de almacenamiento. También puede

ser un lector de CD o DVD mediante un software emulador. Estos emuladores

permiten montar un DVD o un CD directamente desde su imagen de disco, sin que

se tenga que grabar físicamente. Se suele utilizar para instalar o hacer

funcionar juegos y programas de ordenador, utilizando programas como Alcohol

120%, Daemon tools o Isobuster.

lunes, 22 de julio de 2013

LOS MICROPROCESADORES

Microprocesador

Procesador AMD Athlon 64 X2 conectado en el zócalo de una placa base.

Es el encargado de ejecutar los programas, desde el sistema operativo hasta las aplicaciones de usuario; sólo ejecuta instrucciones programadas en lenguaje de bajo nivel, realizando operaciones aritméticas y lógicas simples, tales como sumar, restar, multiplicar, dividir, las lógicas binarias y accesos a memoria.

Esta unidad central de procesamiento está constituida, esencialmente, por registros, una unidad de control, una unidad aritmético lógica (ALU) y una unidad de cálculo en coma flotante(conocida antiguamente como «co-procesador matemático»).

El microprocesador está conectado generalmente mediante un zócalo específico de la placa base de la computadora; normalmente para su correcto y estable funcionamiento, se le incorpora un sistema de refrigeración que consta de un disipador de calor fabricado en algún material de alta conductividad térmica, como cobre o aluminio, y de uno o más ventiladores que eliminan el exceso del calor absorbido por el disipador. Entre el disipador y la cápsula del microprocesador usualmente se coloca pasta térmica para mejorar la conductividad del calor. Existen otros métodos más eficaces, como la refrigeración líquida o el uso de células peltier para refrigeración extrema, aunque estas técnicas se utilizan casi exclusivamente para aplicaciones especiales, tales como en las prácticas de overclocking.

La medición del rendimiento de un microprocesador es una tarea compleja, dado que existen diferentes tipos de "cargas" que pueden ser procesadas con diferente efectividad por procesadores de la misma gama. Una métrica del rendimiento es la frecuencia de reloj que permite comparar procesadores con núcleos de la misma familia, siendo este un indicador muy limitado dada la gran variedad de diseños con los cuales se comercializan los procesadores de una misma marca y referencia. Un sistema informático de alto rendimiento puede estar equipado con varios microprocesadores trabajando en paralelo, y un microprocesador puede, a su vez, estar constituido por varios núcleos físicos o lógicos. Un núcleo físico se refiere a una porción interna del microprocesador cuasi-independiente que realiza todas las actividades de una CPU solitaria, un núcleo lógico es la simulación de un núcleo físico a fin de repartir de manera más eficiente el procesamiento. Existe una tendencia de integrar el mayor número de elementos dentro del propio procesador, aumentando así la eficiencia energética y la miniaturización. Entre los elementos integrados están las unidades de punto flotante, controladores de la memoria RAM, controladores de buses y procesadores dedicados de video.

Historia de los microprocesadores[editar]

La evolución del microprocesador[editar]

El microprocesador es producto surgido de la evolución de distintas tecnologías predecesoras, básicamente de la computación y de la tecnología de semiconductores. El inicio de esta última data de mitad de la década de 1950; estas tecnologías se fusionaron a principios de los años 1970, produciendo el primer microprocesador. Dichas tecnologías iniciaron su desarrollo a partir de la segunda guerra mundial; en este tiempo los científicos desarrollaron computadoras específicas para aplicaciones militares. En la posguerra, a mediados de la década de 1940, la computación digital emprendió un fuerte crecimiento también para propósitos científicos y civiles. La tecnología electrónica avanzó y los científicos hicieron grandes progresos en el diseño de componentes de estado sólido (semiconductores). En 1948 en los laboratorios Bell crearon el transistor.En los años 1950, aparecieron las primeras computadoras digitales de propósito general. Se fabricaron utilizando tubos al vacío o bulbos como componentes electrónicos activos. Módulos de tubos al vacío componían circuitos lógicos básicos, tales como compuertas y flip-flops. Ensamblándolos en módulos se construyó la computadora electrónica (la lógica de control, circuitos de memoria, etc.). Los tubos de vacío también formaron parte de la construcción de máquinas para la comunicación con las computadoras.

Para la construcción de un circuito sumador simple se requiere de algunas compuertas lógicas. La construcción de una computadora digital precisa numerosos circuitos o dispositivos electrónicos. Un paso trascendental en el diseño de la computadora fue hacer que el dato fuera almacenado en memoria. Y la idea de almacenar programas en memoria para luego ejecutarlo fue también de fundamental importancia (Arquitectura de von Neumann).

La tecnología de los circuitos de estado sólido evolucionó en la década de 1950. El empleo del silicio, de bajo costo y con métodos de producción masiva, hicieron del transistor el componente más usado para el diseño de circuitos electrónicos. Por lo tanto el diseño de la computadora digital tuvo un gran avance con el reemplazo del tubo al vacío por el transistor, a finales de la década de 1950.

A principios de la década de 1960, el estado de arte en la construcción de computadoras de estado sólido sufrió un notable avance; surgieron las tecnologías en circuitos digitales como: RTL (Lógica Transistor Resistor), DTL (Lógica Transistor Diodo), TTL (Lógica Transistor Transistor), ECL (Lógica Complementada Emisor).

A mediados de los años 1960 se producen las familias de circuitos de lógica digital, dispositivos integrados en escala SSI y MSI que corresponden a baja y mediana escala de integración de componentes. A finales de los años 1960 y principios de los 70 surgieron los sistemas a alta escala de integración o LSI. La tecnología LSI fue haciendo posible incrementar la cantidad de componentes en los circuitos integrados. Sin embargo, pocos circuitos LSI fueron producidos, los dispositivos de memoria eran un buen ejemplo.

Las primeras calculadoras electrónicas requerían entre 75 y 100 circuitos integrados. Después se dio un paso importante en la reducción de la arquitectura de la computadora a un circuito integrado simple, resultando uno que fue llamado microprocesador, unión de las palabras «Micro» del griego μικρο-, «pequeño», y procesador. Sin embargo, es totalmente válido usar el término genérico procesador, dado que con el paso de los años, la escala de integración se ha visto reducida de micrométrica a nanométrica; y además, es, sin duda, un procesador.

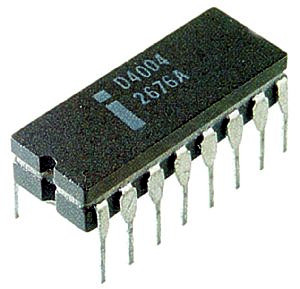

- El primer microprocesador fue el Intel 4004,[1] producido en 1971. Se desarrolló originalmente para una calculadora y resultó revolucionario para su época. Contenía 2.300 transistores, era un microprocesador de arquitectura de 4 bits que podía realizar hasta 60.000 operaciones por segundo trabajando a una frecuencia de reloj de alrededor de 700KHz.

- El primer microprocesador de 8 bits fue el Intel 8008, desarrollado a mediados de 1972 para su uso en terminales informáticos. El Intel 8008 integraba 3300 transistores y podía procesar a frecuencias máximas de 800Khz.

- El primer microprocesador realmente diseñado para uso general, desarrollado en 1974, fue el Intel 8080 de 8 bits, que contenía 4500 transistores y podía ejecutar 200.000 instrucciones por segundo trabajando a alrededor de 2MHz.

- El primer microprocesador de 16 bits fue el 8086. Fue el inicio y el primer miembro de la popular arquitectura x86, actualmente usada en la mayoría de los computadores. El chip 8086 fue introducido al mercado en el verano de 1978, pero debido a que no había aplicaciones en el mercado que funcionaran con 16 bits, Intel sacó al mercado el 8088, que fue lanzado en 1979. Llegaron a operar a frecuencias mayores de 4Mhz.

- El microprocesador elegido para equipar al IBM Personal Computer/AT, que causó que fuera el más empleado en los PC-AT compatibles entre mediados y finales de los años 1980 fue el Intel 80286 (también conocido simplemente como 286); es un microprocesador de 16 bits, de la familia x86, que fue lanzado al mercado en 1982. Contaba con 134.000 transistores. Las versiones finales alcanzaron velocidades de hasta 25 MHz.

- Uno de los primeros procesadores de arquitectura de 32 bits fue el 80386 de Intel, fabricado a mediados y fines de la década de 1980; en sus diferentes versiones llegó a trabajar a frecuencias del orden de los 40Mhz.

- El microprocesador DEC Alpha se lanzó al mercado en 1992, corriendo a 200 MHz en su primera versión, en tanto que el Intel Pentium surgió en 1993 con una frecuencia de trabajo de 66Mhz. El procesador Alpha, de tecnología RISC y arquitectura de 64 bits, marcó un hito, declarándose como el más rápido del mundo, en su época. Llegó a 1Ghz de frecuencia hacia el año 2001. Irónicamente, a mediados del 2003, cuando se pensaba quitarlo de circulación, el Alpha aun encabezaba la lista de los microprocesadores más rápidos de Estados Unidos.[2]

- Los microprocesadores modernos tienen una capacidad y velocidad mucho mayores, trabajan en arquitecturas de 64 bits, integran más de 700 millones de transistores, como es en el caso de las serie Core i7, y pueden operar a frecuencias normales algo superiores a los 3GHz (3000MHz).

Breve historia[editar]

Hasta los primeros años de la década de 1970 los diferentes componentes electrónicos que formaban un procesador no podían ser un único circuito integrado, era necesario utilizar dos o tres "chips" para hacer una CPU (un era el "ALU" - Arithmetical Logic Unit, el otro la " control Unit", el otro el " Register Bank", etc..). En 1971 la compañía Intel consiguió por primera vez poner todos los transistores que constituían un procesador sobre un único circuito integrado, el"4004 "', nacía el microprocesador.Seguidamente se expone una lista ordenada cronológicamente de los microprocesadores más populares que fueron surgiendo. En la URSS se realizaron otros sistemas que dieron lugar a la serie microprocesador Elbrus.

- 1971: El Intel 4004

- 1972: El Intel 8008

- 1974: El SC/MP

- 1974: El Intel 8080

- 1975: Motorola 6800

- 1976: El Z80

- 1978: Los Intel 8086 y 8088

- 1982: El Intel 80286

- 1985: El Intel 80386

- 1985: El VAX 78032

- 1989: El Intel 80486

- 1991: El AMD AMx86

- 1993: PowerPC 601

- 1993: El Intel Pentium

- 1994: EL PowerPC 620

- 1995: EL Intel Pentium Pro

- 1996: El AMD K5

- 1996: Los AMD K6 y AMD K6-2

Más adelante se lanzó una mejora de los K6, los K6-2 de 250 nanómetros, para seguir compitiendo con los Pentium II, siendo éste último superior en tareas de coma flotante, pero inferior en tareas de uso general. Se introduce un juego de instrucciones SIMD denominado 3DNow!

- 1997: El Intel Pentium II

- 1998: El Intel Pentium II Xeon

- 1999: El Intel Celeron

- 1999: El AMD Athlon K7 (Classic y Thunderbird)

El procesador Athlon con núcleo Thunderbird apareció como la evolución del Athlon Classic. Al igual que su predecesor, también se basa en la arquitectura x86 y usa el bus EV6. El proceso de fabricación usado para todos estos microprocesadores es de 180 nanómetros. El Athlon Thunderbird consolidó a AMD como la segunda mayor compañía de fabricación de microprocesadores, ya que gracias a su excelente rendimiento (superando siempre al Pentium III y a los primeros Pentium IV de Intel a la misma frecuencia de reloj) y bajo precio, la hicieron muy popular tanto entre los entendidos como en los iniciados en la informática.

- 1999: El Intel Pentium III

- 1999: El Intel Pentium III Xeon

- 2000: EL Intel Pentium 4

- 2001: El AMD Athlon XP

- 2004: El Intel Pentium 4 (Prescott)

- 2004: El AMD Athlon 64

- 2006: EL Intel Core Duo

- 2007: El AMD Phenom

- 2008: El Intel Core Nehalem

- 2008: Los AMD Phenom II y Athlon II

Entre ellos, el Amd Phenom II X2 BE 555 de doble núcleo surge como el procesador binúcleo del mercado. También se lanzan tres Athlon II con sólo Caché L2, pero con buena relación precio/rendimiento. El Amd Athlon II X4 630 corre a 2,8 GHz. El Amd Athlon II X4 635 continua la misma línea.

AMD también lanza un triple núcleo, llamado Athlon II X3 440, así como un doble núcleo Athlon II X2 255. También sale el Phenom X4 995, de cuatro núcleos, que corre a más de 3,2GHz. También AMD lanza la familia Thurban con 6 núcleos físicos dentro del encapsulado

- 2011: El Intel Core Sandy Bridge

Intel lanzó sus procesadores que se conocen con el nombre en clave Sandy Bridge. Estos procesadores Intel Core que no tienen sustanciales cambios en arquitectura respecto a nehalem, pero si los necesarios para hacerlos más eficientes y rápidos que los modelos anteriores. Es la segunda generación de los Intel Core con nuevas instrucciones de 256 bits, duplicando el rendimiento, mejorando el desempeño en 3D y todo lo que se relacione con operación en multimedia. Llegaron la primera semana de enero del 2011. Incluye nuevo conjunto de instrucciones denominado AVX y una GPU integrada de hasta 12 unidades de ejecución

- 2011: El AMD Fusion

- 2012: El Intel Core Ivy Bridge

Funcionamiento[editar]

Desde el punto de vista lógico, singular y funcional, el microprocesador está compuesto básicamente por: varios registros, una unidad de control, una unidad aritmético lógica, y dependiendo del procesador, puede contener una unidad de coma flotante.El microprocesador ejecuta instrucciones almacenadas como números binarios organizados secuencialmente en la memoria principal. La ejecución de las instrucciones se puede realizar en varias fases:

- Prefetch, prelectura de la instrucción desde la memoria principal.

- Fetch, envío de la instrucción al decodificador

- Decodificación de la instrucción, es decir, determinar qué instrucción es y por tanto qué se debe hacer.

- Lectura de operandos (si los hay).

- Ejecución, lanzamiento de las máquinas de estado que llevan a cabo el procesamiento.

- Escritura de los resultados en la memoria principal o en los registros.

Rendimiento[editar]

El rendimiento del procesador puede ser medido de distintas maneras, hasta hace pocos años se creía que la frecuencia de reloj era una medida precisa, pero ese mito, conocido como «mito de los megahertzios» se ha visto desvirtuado por el hecho de que los procesadores no han requerido frecuencias más altas para aumentar su potencia de cómputo.Durante los últimos años esa frecuencia se ha mantenido en el rango de los 1,5 GHz a 4 GHz, dando como resultado procesadores con capacidades de proceso mayores comparados con los primeros que alcanzaron esos valores. Además la tendencia es a incorporar más núcleos dentro de un mismo encapsulado para aumentar el rendimiento por medio de una computación paralela, de manera que la velocidad de reloj es un indicador menos fiable aún. De todas maneras, una forma fiable de medir la potencia de un procesador es mediante la obtención de las Instrucciones por ciclo

Medir el rendimiento con la frecuencia es válido únicamente entre procesadores con arquitecturas muy similares o iguales, de manera que su funcionamiento interno sea el mismo: en ese caso la frecuencia es un índice de comparación válido. Dentro de una familia de procesadores es común encontrar distintas opciones en cuanto a frecuencias de reloj, debido a que no todos los chip de silicio tienen los mismos límites de funcionamiento: son probados a distintas frecuencias, hasta que muestran signos de inestabilidad, entonces se clasifican de acuerdo al resultado de las pruebas.

Esto se podría reducir en que los procesadores son fabricados por lotes con diferentes estructuras internas atendidendo a gamas y extras como podría ser una memoria caché de diferente tamaño, aunque no siempre es así y las gamas altas difieren muchísimo más de las bajas que simplemente de su memoria caché. Después de obtener los lotes según su gama, se someten a procesos en un banco de pruebas, y según su soporte a las temperaturas o que vaya mostrando signos de inestabilidad, se le adjudica una frecuencia, con la que vendrá programado de serie, pero con prácticas de overclock se le puede incrementar

La capacidad de un procesador depende fuertemente de los componentes restantes del sistema, sobre todo del chipset, de la memoria RAM y del software. Pero obviando esas características puede tenerse una medida aproximada del rendimiento de un procesador por medio de indicadores como la cantidad de operaciones de coma flotante por unidad de tiempo FLOPS, o la cantidad de instrucciones por unidad de tiempo MIPS. Una medida exacta del rendimiento de un procesador o de un sistema, es muy complicada debido a los múltiples factores involucrados en la computación de un problema, por lo general las pruebas no son concluyentes entre sistemas de la misma generación.

Suscribirse a:

Entradas (Atom)